「データ漏洩が心配」「コストが重荷」そんな不安を抱えていませんか?

Dify ローカル版は、自社サーバー内で完結する安全性と低コスト運用を実現。標準搭載のRAG機能で精度も抜群です。

この記事では、ローカル版Difyの魅力からインストール方法、活用例まで徹底解説します。AI導入をためらってきた企業にこそ、知っていただきたい内容です。ぜひ最後までお読みいただき、あなたのビジネスを変革するDifyの可能性を探ってみてください。

Tom(@0x__tom)

代表取締役 CEO

Dify を活用した企業の DX 支援や AI エージェント事業などに取り組む株式会社MYUUUという生成AIスタートアップの代表。生成AIユーザーが1,400名所属し、Difyの最新ユースケースを学び合うコミュニティ「FRACTAL LAB」を運営しています。

Difyとは?LLMアプリ開発の革命児

まずDifyは誰でも簡単にAIアプリを作れる画期的なプラットフォームです。プログラミング知識がなくても、直感的な操作で高度なAIアプリケーションを開発できます。ノーコードからローコードまで、柔軟な開発環境を提供しています。

特にRAG(検索拡張生成)機能を標準搭載した点は注目すべきです。自社のデータやドキュメントをAIに学習させ、より正確な回答を導き出せます。ナレッジベースとの連携も簡単です。

さらにDifyはオープンソースとして公開されています。GitHubで全ソースコードにアクセス可能で、様々な大手企業やスタートアップでも採用実績があります。LLMOpsの基盤として、AIアプリ開発のエコシステムを支えています。

マルチモーダルにも対応しており、テキストだけでなく画像処理も可能。他システムとの連携も柔軟に行えるため、既存のワークフローに組み込みやすいでしょう。

Tom

TomDifyはマジで革命的なツールです。すでにIT企業の50%が知ってるレベル!

ローカル版Difyの環境構築と初期設定

Docker Composeを使った最速セットアップ

Difyを動作させるのに必要な環境は以下のとおりで、かなりシンプルです。

まずDifyを動かすのに必要な環境を次の表にまとめます。

| CPU | 2コア以上 |

|---|---|

| メモリー(RAM) | 4GB以上 |

| 必要なソフトウェア | Git、Docker Desktop |

インストールから立ち上げまでは、Windowsの「コマンドプロンプト」もしくは「PowerShell」、MacOSXやLinuxの「ターミナル」で下記のコマンドを1行ずつ実行するだけでOK。

この記事ではMacOSXで行っていきます。

git clone https://github.com/langgenius/dify.git --branch 1.0.0

cd dify/docker

docker compose up -d http://localhost:3001difyは頻繁にアップデートされるので、アップデートの方法も紹介します。

cd dify/docker

git pull origin main

docker compose down

docker compose pull

docker compose up -d

ローカル版DifyのインストールはDocker Composeが一番楽です。コピペ3分で終わります!

ローカル版Difyの初回ログイン

Difyの起動後、ブラウザで「http://localhost」にアクセスします。初回は管理者アカウントの作成画面が表示されます。メールアドレスとパスワードを設定しましょう。パスワードは8文字以上の英数字を推奨します。

ログイン後は日本語、タイムゾーンを変更しましょう。画面右上のユーザーアイコンをクリック→プルダウンメニューから設定→現れた設定画面の「言語」で設定を変更できます。

初期設定では「探索」「スタジオ」「ナレッジ」「ツール」の4つのメニューが表示されます。「探索」から始めると全体像を把握できるでしょう。

LLMモデルの設定

OpenAIやClaudeなどのクローズLLMの場合

APIキーの設定は画面右上のユーザーアイコンから「設定」を選択します。左メニューの「モデルプロバイダー」をクリックすると、OpenAIやAnthropicのモデルプロバイダーをインストールする項目が表示されます。モデルプロバイダーをインストールした後、各サービスの利用したいモデル名やAPIキーを入力し、「保存」をクリックすれば連携できます。

複数のモデルを登録しておくと、アプリ作成時に最適なモデルを選択できます。無料枠のあるGeminiや格安のDeepSeek、gpt-4o-miniなどのAPIキーから試すと初期コストを抑えられるでしょう。

OllamaなどのローカルLLMの場合

ローカルLLMを使う場合、Ollamaの導入がおすすめです。Ollamaをインストールし、利用したいモデルをあらかじめダウンロードしておきます。Difyの設定画面でモデルプロバイダーollamaをインストールし、利用したいモデル名やBaseURLを入力し「保存」をクリックすれば連携できます。

ローカルLLMの設定方法はこちらの記事がわかりやすいです!

Difyをローカル環境で動かす5つのメリット

DifyはWeb版だけでなくローカル環境でも利用できます。ローカル環境ならではの魅力を5つご紹介します。

セキュリティとプライバシー保護の強化

ローカル版Difyは優れたセキュリティを提供します。データは自社サーバー内に留まり、外部に漏れる心配はありません。社外秘情報も安心して処理できます。

保険・金融・医療業界など厳格な情報管理が求められる分野に最適です。法的規制の厳しい業界でも安全にAIを活用できます。個人情報や機密文書も社内で完結します。

コスト削減

ローカル版Difyは完全無料で、Web版と同一の機能を制限なく使えます。ただし、GPUやストレージは自前で用意する必要があります。商用利用も基本的に許可されています。社内ツールとして活用する場合は費用がかかりません。長期運用を考えるとコスト面で大きな優位性があります。

オフライン環境での利用

ローカル版Difyはインターネット接続なしでも動作します。小型LLMと組み合わせれば完全オフラインで使えます。電波の届かない場所でも問題ありません。

高速処理とパフォーマンス

ローカル版Difyは通信によるタイムラグがありません。レスポンス速度はWeb版より明らかに速いです。特に大量データ処理で差が顕著に現れます。高性能なハードウェアを用意すれば処理速度はさらに向上するので、ユーザー体験も格段に向上します。

カスタマイズの自由度

ローカル版Difyでは独自モデルとの連携も自由自在です。そのため、自社のニーズに合わせた最適化が可能です。特定業務向けの専用設定も簡単に行えます。

セキュリティとコスト面だけでもローカル版Difyは検討する価値アリ!CODE_MAX_STRING_LENGTHなど環境変数を変えたいときにもローカルDifyの活用がおすすめです!

ローカル版Difyの高度な活用法

もしかしたらローカル版Difyを一時的に外部へ公開したい時があるかもしれません。その際の注意点と方法を解説します。

外部公開の注意点

セキュリティリスク

外部公開にはセキュリティ上の懸念が伴います。

デフォルトの設定では全てのアドレスからのリクエストを許可しているため、不正アクセスの危険性があります。公開時には、許可するオリジンを必要最小限に制限する必要があります。もし機密情報や個人情報を含むデータを扱う時は特に注意が必要です。テスト用のダミーデータを使用するか、データマスキング処理を施すことを検討しましょう。さらに外部公開中は、アクセスログやシステムの挙動を常に監視する体制が必須です。不審なアクティビティを早期に検知できる仕組みを整え、インシデント発生時の対応手順も事前に準備しておきましょう。

一時的アクセスの管理

短期間アクセスの実装が重要です。外部公開する時間を必要最小限に限定することで、リスクを低減できます。VPNを通じたセキュアなアクセス提供も効果的な対策です。

リソース消費の増加

外部からのアクセスが増えると、サーバーリソースの消費も増加します。特に大量のリクエストが予想される場合は、リソース制限やレート制限の設定を検討しましょう。

外部公開を行う際は、ngrokやCloudflare Tunnelなどのツールを活用し、Basic認証やIP制限などの保護措置を必ず実装してください。また、公開期間を明確に定め、必要な期間が終了したら速やかに公開を停止することが重要です。ここで、ngrokを使ったDifyの外部公開手順を紹介します。

ngrokを使ったDify外部公開の手順

ngrok公式サイトにアクセスし、無料アカウントを作成します

メールアドレスでの登録か、GitHubやGoogleアカウントでのソーシャルログインを選択します

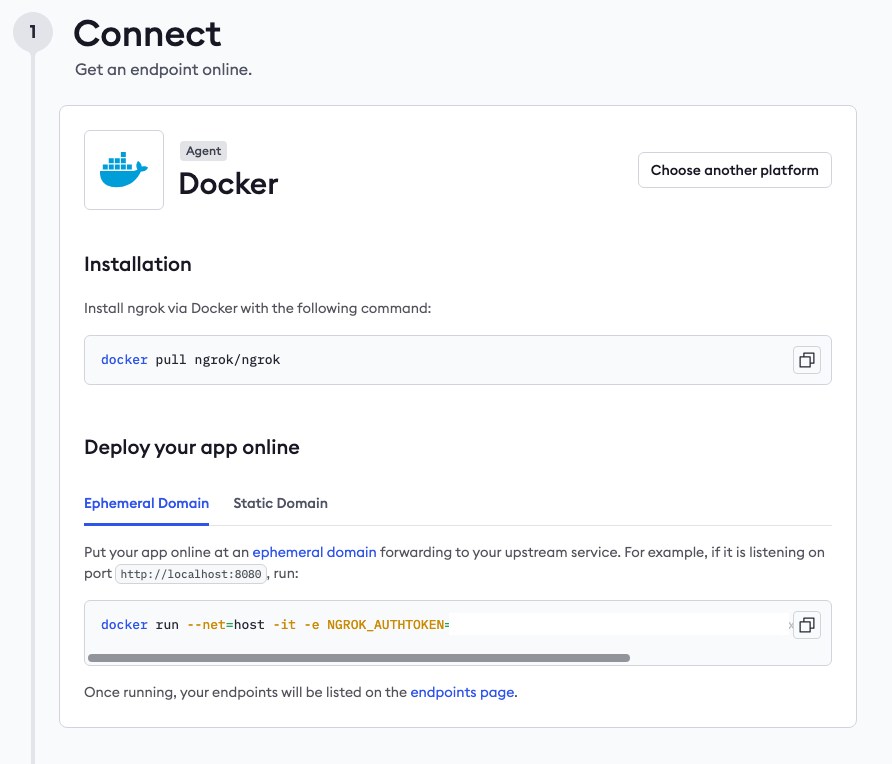

ログイン後、図の通りにDockerを選択して表示されるセットアップを順に実施します。

接続を確認するだけなら「Connect」の手順を実行しましょう。

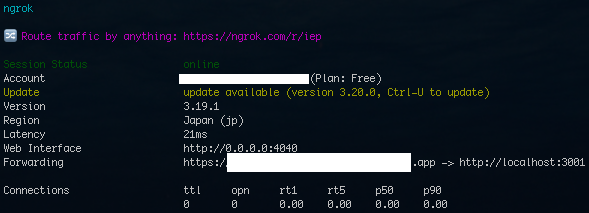

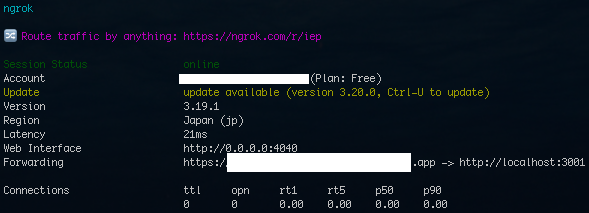

成功すると次の画面がターミナルに表示されます。

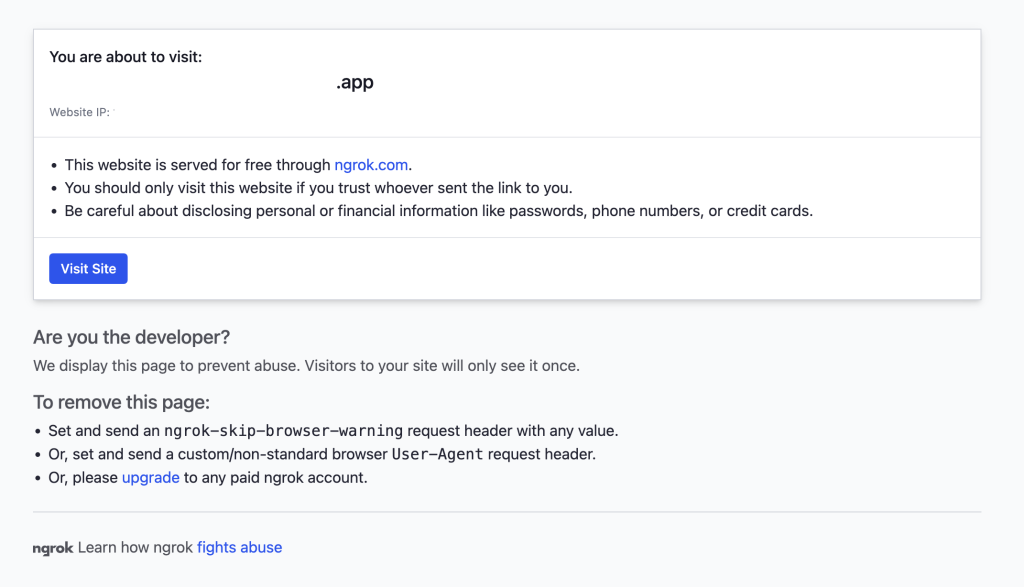

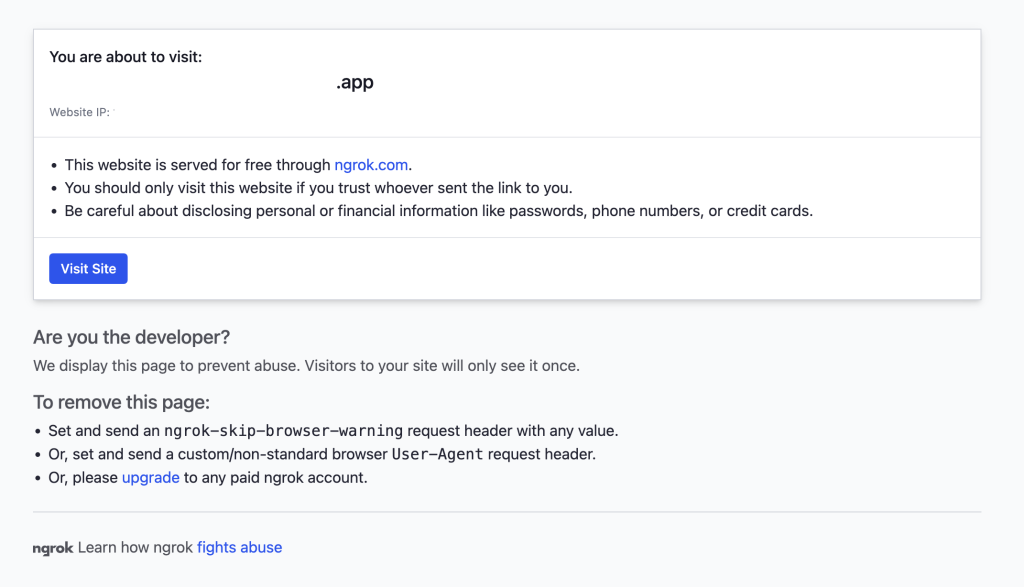

指定されたURLにアクセスすると図のような画面が表示され、「Visit Site」をクリックするとローカル版Difyに接続できます。Fowardingに示されたURLであればGASやFirecrawlなどと連携させされます。

ローカル版Difyのよくある質問と解決策

ここではローカル版Difyのよくある質問とその解決策を紹介します。

パスワードを忘れた

- Dockerコンテナが起動していることを確認した上で、APIコンテナにアクセス

docker exec -it docker-api-1 flask reset-password- プロンプトに従って、リセットするアカウントのメールアドレスを入力し、新しいパスワードを設定します。

ポート80番以外でローカル版Difyにアクセスしたい

docker-compse.yamlのEXPOSE_NGINX_PORTを80から8080に変えます。

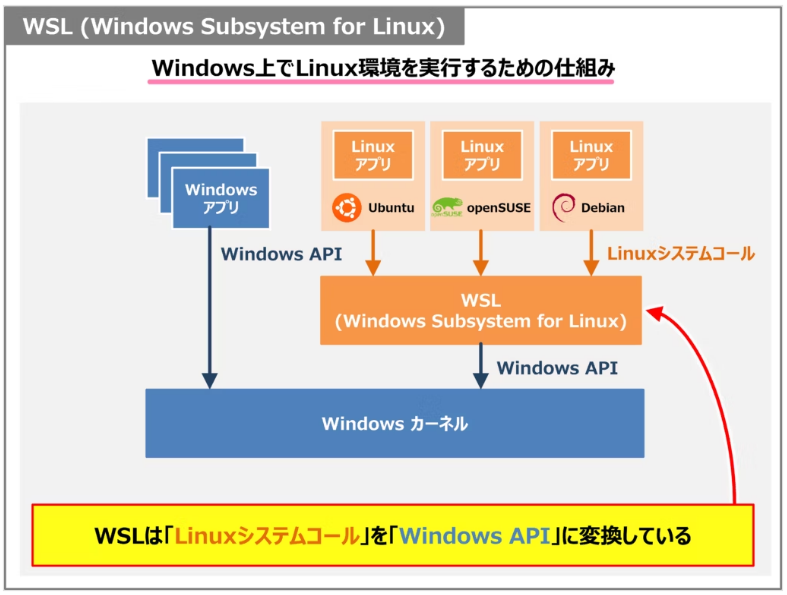

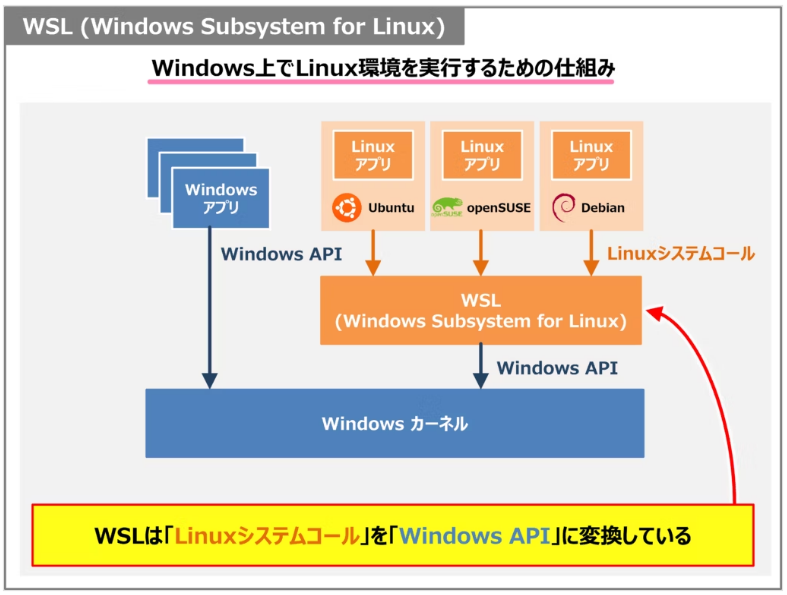

ローカルLLMと接続できない

dockerのネットワークは図のようになっています。ローカル版Difyはdocker上に構築されるため、「host.docker.internal」を介した通信ができません。例えばollamaをwindowsに直接インストールした際、Difyとの連携には「http://host.docker.internal:11434」ではなく、「http://{ローカルIPアドレス}:11434」を設定しましょう。他のシステムを連携させる時も同様です。

ローカル版Difyの問題の多くはDockerに関係するので、この章は要チェックです!

まとめ

DifyはAIアプリ開発を革新するプログラミング不要でチャットボットやAIエージェントを構築できるプラットフォームです。ローカル環境での運用は、セキュリティ強化、コスト削減、オフライン利用、高速処理、カスタマイズの自由度と、5つのメリットがあります。

本記事では、Docker Composeを使った簡単なセットアップ方法、OpenAIやClaudeなどのクラウドLLM、Ollamaなどのローカルモデルとの連携設定、パスワードリセットやポート変更などのトラブルシューティング、ngrokを使った外部公開方法までを解説しました。

ローカル版Difyは、セキュリティやコスト面の制約で生成AI導入を見送ってきた企業にとって最適な選択肢です。この記事の知識を活用し、自社のニーズに合わせたAIアプリケーションを構築してください。