「ChatGPTのような高性能AIを自社サーバーで動かせたら…」

「プライバシーを気にせず使えるAIチャットボットが欲しい…」

「クラウドAIの月額料金が高くて困っている…」

そんな悩みをお持ちではありませんか?

このガイドでは、OllamaとDifyという2つの革新的なツールを組み合わせて、プライベートAIチャットボットを構築する方法を解説します。

Tom(@0x__tom)

代表取締役 CEO

Dify を活用した企業の DX 支援や AI エージェント事業などに取り組む株式会社MYUUUという生成AIスタートアップの代表。生成AIユーザーが1,400名所属し、Difyの最新ユースケースを学び合うコミュニティ「FRACTAL LAB」を運営しています。

Ollamaとは?

Ollamaは、最新のAI技術(LLM:大規模言語モデル)を自分のパソコンで動かすためのソフトウェアです。コマンドを入力する方法と、他のソフトから呼び出す方法(API)の両方で使えます。Ollamaには、3つの大きな魅力があります。

完全なプライバシー保護

Ollamaは、すべての処理がパソコン内で完結します。データはインターネット上に送信されず、ローカル環境だけで動作するので、機密情報や個人情報を扱う際も安心できます。企業の内部文書や個人データの分析でも、情報漏洩のリスクなく利用可能です。クラウドAIでは難しいセキュリティ要件の厳しい環境でも、安心してAIを活用できます。

コスト削減と無制限の利用

多くのクラウドAIサービスは使用量に応じた料金が発生します。しかしOllamaは完全に無料で利用できるのが特徴です。AIの利用量が増えても追加費用は一切かかりません。予算の制約を気にせず、思う存分AIを活用できます。特に大量のデータ処理や頻繁なAI利用が必要な場面では、このコスト面での利点は非常に大きな価値を持ちます。

多様なモデルとカスタマイズ性

Ollamaは様々な種類のAIモデルに対応しています。用途に合わせて最適なモデルを選べるのが魅力的です。文章生成に特化したものから、コード補完に優れたもの、多言語対応のものまで、目的に応じて使い分けられます。ダウンロードしたモデルは自分の好みや使用目的に合わせてカスタマイズも可能です。より精度の高い結果を得られます。

このように、Ollamaはプライバシー保護、コスト削減、そして多様なモデル選択という3つの核となる利点を兼ね備えています。個人利用から企業の業務まで幅広い場面で活躍します。

Ollamaのインストール方法

ここからはOllamaを使うためのインストール方法を解説します。Ollamaを使うには、次のシステム要件が必要なのであらかじめ確認しておきましょう。

- MacOS 11(Big Sur)以上、Linux、Windows10以上

- 16GB以上のメモリーが推奨されているが、最低8GBあれば動く

- モデルによって異なるものの、最低10GB以上の空きが必要

次にそれぞれのOSにおけるインストール方法を紹介します。

WSL(Ubuntu)にインストールする場合

はじめにWSLにインストールする方法を紹介します。WSLはWindows上でLinux環境を実行できる機能です。 DifyとOllamaを初めて連携させたいWindowsユーザーの方はこの方法をオススメします。なお結果的にLinuxにインストールするので、LinuxにOllamを導入したい方も参考にしてください。

WSL2のインストール

- Windowsを再起動したら、「コマンドプロンプト」または「PowerShell」を管理者権限で開きます(スタートメニューで右クリックして「管理者として実行」を選びます)。

- 次のコマンドを入力して実行し、終了後にPCを再起動します。

wsl --install- 再起動後、powershellもしくはコマンドラインを開き、wslを実行してUbuntuを起動します。

- 初回起動時はUbuntuのユーザー名とパスワードの設定を求められるので、それぞれ入力します。ここで作成されるアカウントが規定のユーザーとして設定され、接続時、自動的にサインインするようになります。

Ollamaのインストール

- wslを実行し、Ubuntuを起動します。

- Ubuntuのソフトウェアを最新の状態にするために、次のコマンドを実行します。

sudo apt update && sudo apt upgrade- パスワードを求められたら、先ほど設定したパスワードを入力します。

- 次に、Ollamaをインストールするために、以下のコマンドを実行します。

curl -fsSL https://ollama.com/install.sh | shOllamaサービスの設定

- Ollamaを常時起動させるために、次のコマンドを実行します。

sudo useradd -r -s /bin/false -m -d /usr/share/ollama ollama- 次に、サービス設定ファイルを作成します。以下のコマンドを実行します。

sudo nano /etc/systemd/system/ollama.service- 開いたエディタに、次の内容を入力します。

[Unit]

Description=Ollama Service

After=network-online.target

[Service]

User=ollama

Group=ollama

ExecStart=/usr/local/bin/ollama serve

Restart=always

RestartSec=3

[Install]

WantedBy=default.target- 入力が終わったら、Ctrl+O、Enterでファイルを保存し、Ctrl+Xで編集を終了します。

- サービスを有効にするために、次のコマンドを実行します。

sudo systemctl enable ollama.service

sudo systemctl daemon-reload- Ollamaサービスを起動します。

sudo systemctl start ollamaこれでWSL(Ubuntu)環境でのOllamaのインストールと設定が完了しました。少し手順は多いですが、一つずつ進めれば問題なく設定できます。

MacOSにインストールする場合

最後にMacのインストール方法を紹介します。以下の手順を参考に進めてください。

インストーラーファイルのダウンロード

- Ollamaの公式サイト(https://ollama.com/)にアクセスします。

- 「Download」ボタンをクリックします。

- OSの選択画面で「Mac」を選び、「Download for Mac」をクリックし、「Ollama-darwin.zip」を任意のフォルダにダウンロードします。

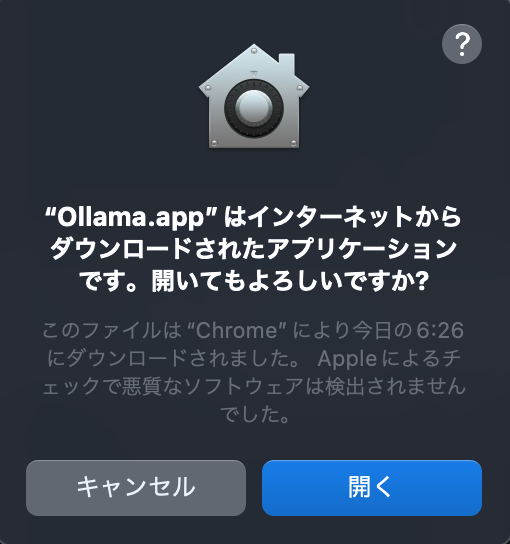

インストーラーの実行

- ダウンロードしたファイルを開封します。

- 「ollama.app」を実行します。

- セキュリティの警告が表示されたら、「開く」(Open)をクリックします

- 「Ollamaはアプリケーションフォルダから実行すると最も効果的に動作します」というメッセージが表示されます。

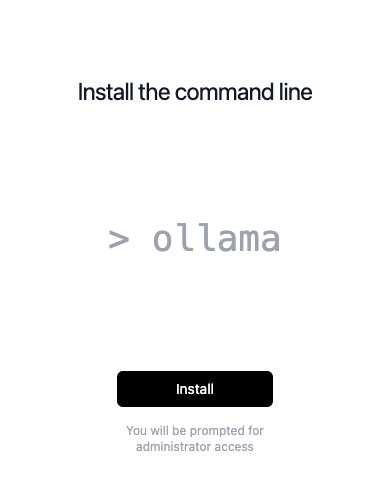

- 「Move to Applications」(アプリケーションに移動)をクリックし、インストールウィザードが開くまで待ちます。

- ウィザードの最初のページで「Next」をクリックします。

- 続いて「Install」をクリックします。

- Macのパスワードの入力を求められるので、入力して「OK」をクリックします。

- インストールが完了したら、「Finish」をクリックしてウィザードを閉じます。

- インストールが成功すると、画面上部のメニューバーにラマのアイコンが表示されます。

Windowsにインストールする場合

WindowsはWSLではなくOllamaを直接インストールする方法もあります。しかし初めてDifyとOllamaの連携をする方は、Difyの仕様からWSLにollamaをインストールをオススメします。それでは直接インストールする方法を解説します。

Ollamaのダウンロード

- Ollamaの公式サイト(https://ollama.com/)にアクセスします。

- 画面中央にある「Download」ボタンをクリックします。

- OSの選択画面が表示されるので、「Windows」を選びます。

- 「Download for Windows」をクリックしてダウンロードを始めます。

- ダウンロードが終わったら、ダウンロードしたファイル(OllamaSetup.exe)をダブルクリックします。

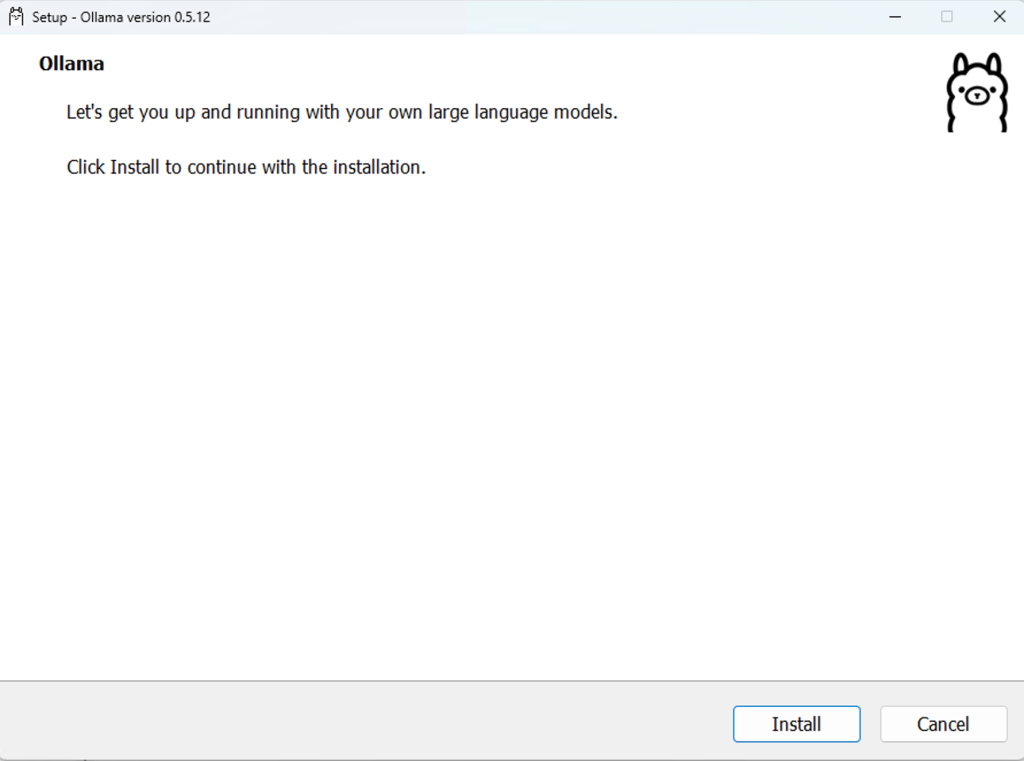

Ollamaのインストール

- インストーラーの画面が表示されたら、「Install」ボタンをクリックします。

- 自動的にインストールが進み、完了します。

Ollamaの動作確認をする

- コマンドラインもしくはpowershellを開きます。

- 「ollama」を実行して、ollamaのUsageが表示されるか確認します。

これだけで、Windowsへのインストールは完了です。 このあとは、使いたいAIモデルをダウンロードして使い始めることができます。

Ollamaの動作確認

- ターミナルを開きます。

- 「ollama」を実行して、ollamaのUsageが表示されるか確認します。

Ollamaのモデルインストール

最後にOllamaへのAIモデルインストール手順を紹介します。

- Ollamaで使いたいAIモデルをダウンロードします。例えば、コマンドラインもしくはターミナルで次のように入力します。llama2の部分は、使いたいモデルの名前に置き換えてください。

ollama pull llama2- モデルをダウンロードしたら、次のコマンドでモデルを起動します。こちらもllama2の部分は、使いたいモデルの名前に置き換えてください。

ollama run llama2Ollamaで利用可能なモデルは公式ページで配布されているものだけでなく、HuggingFaceで公開されているモデルも扱えます。HuggingFaceで公開されているモデルを利用する場合は「ollama run hf.co/{ユーザー名}/{リポジトリ}」を実行すれば、モデルのダウンロードが始まり、起動します。例えば次のコマンドです。

ollama run hf.co/bartowski/Llama-3.2-1B-Instruct-GGUF:latestDifyとOllamaの連携

ローカルDifyを構築する方法

ローカルでDifyとollamaを連携させるには、ローカルにもDifyをインストールするか、Ollamaをインターネットに公開しなければなりません。 この記事ではローカルにDifyをインストールした場合の手順を解説します。

Tom

TomDifyをローカルにインストールしていない方は次の記事を参考にください!

DifyとOllamaの連携方法

ローカルにもDifyをインストールしたら、いよいよDifyとOllamaを連携させていきます。

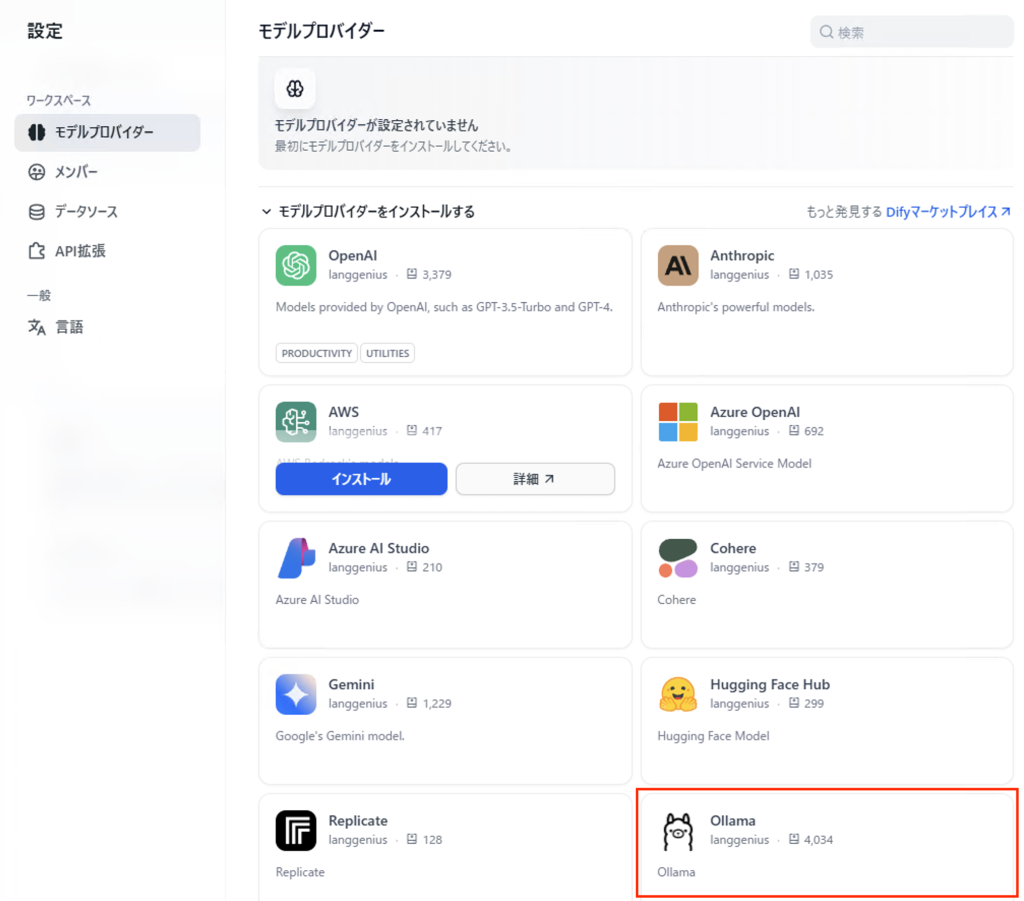

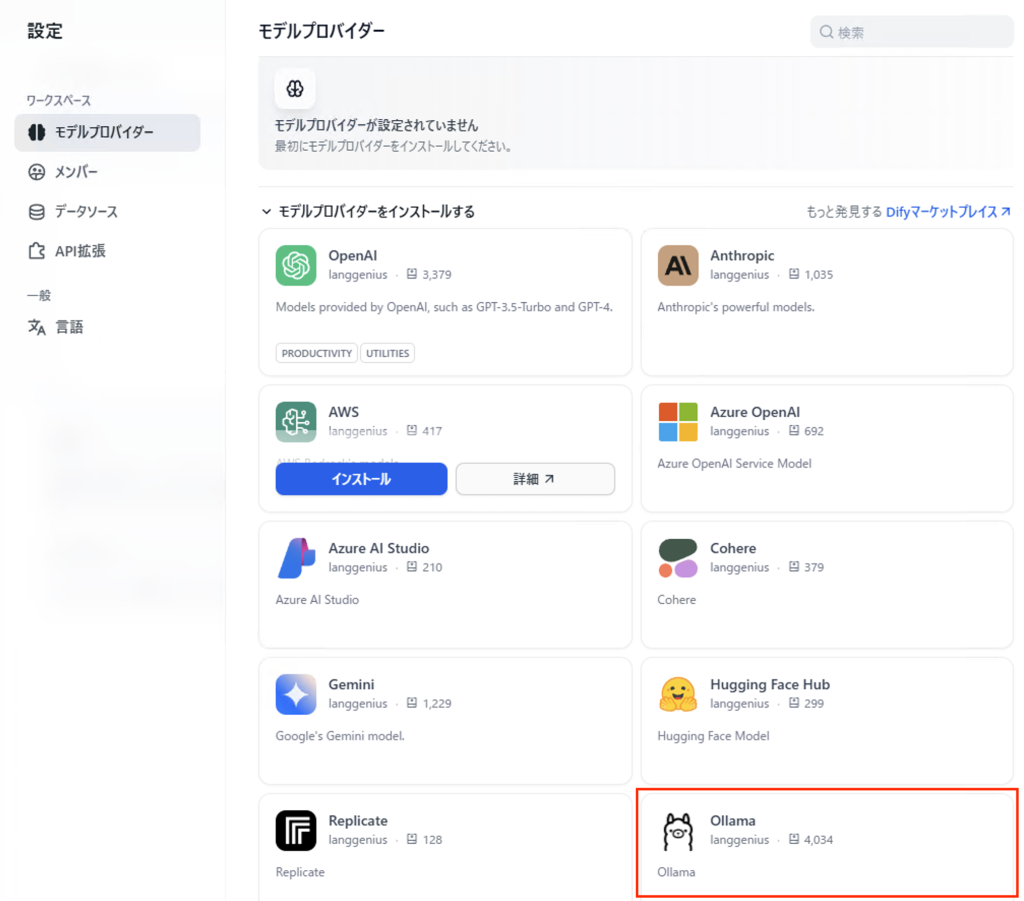

- ローカルDifyの管理画面にログインします。

- 設定メニューから「モデルプロバイダー」を選び、「Ollama」を選択します。

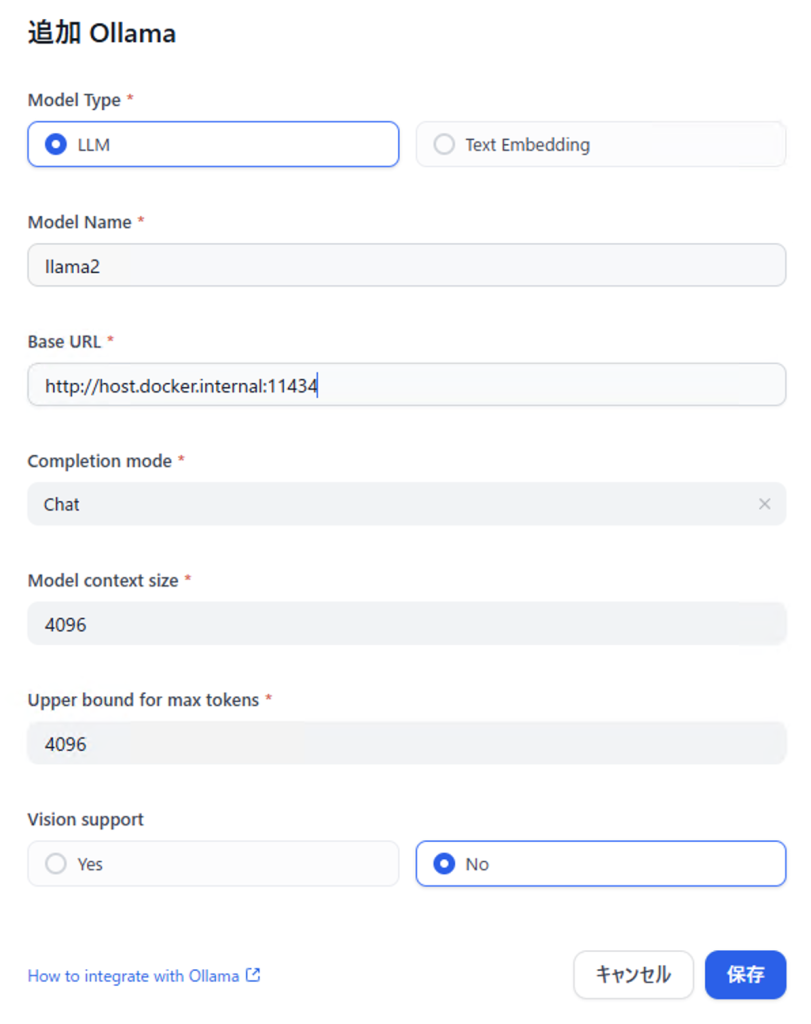

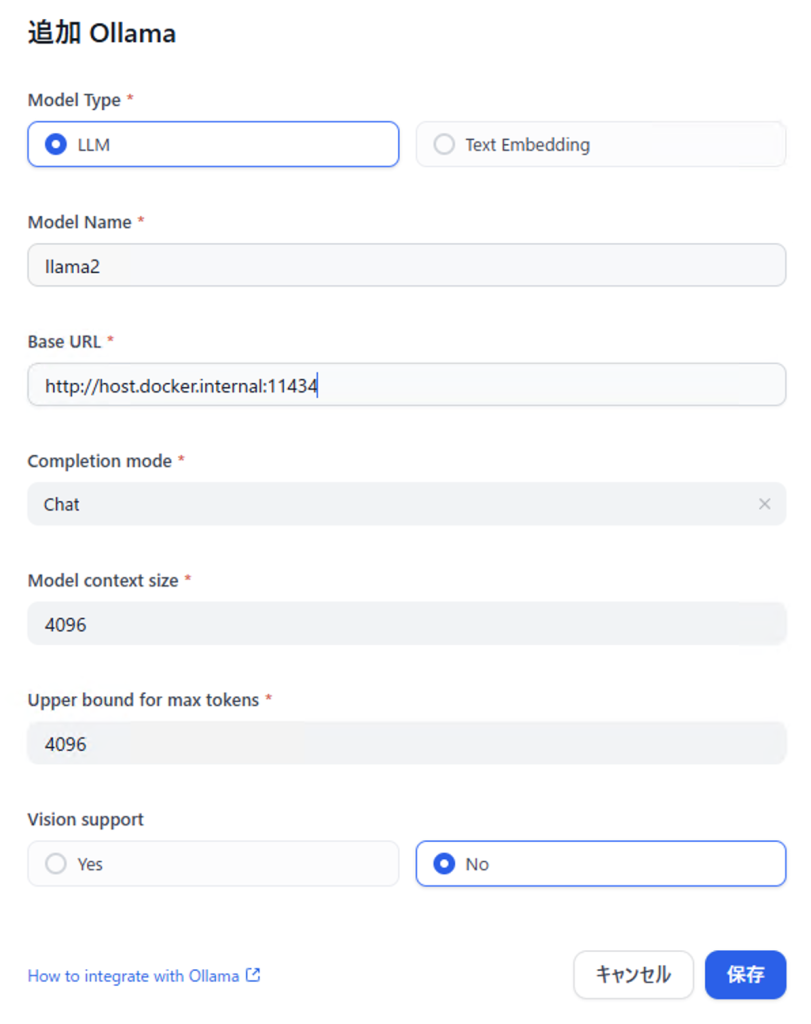

- 以下の情報を入力します:

モデル名:Ollamaで起動したモデルの名前(例:llama2)

モデルタイプ:Chat(チャット用)を選択

モデルコンテキスト長:モデルが一度に処理できる文字数の上限(モデルによって異なる)

最大トークン制限:モデルが一度に返答できる最大の文字数

Visionのサポート:画像認識ができるモデルの場合は「はい」、そうでない場合は「いいえ」

ベースURL:OllamaサービスにアクセスするためのURLを入力| OS | URL | ポート解放 |

| Windows | http://(ローカルIPアドレス):11434 | 必要 |

| WSL(Linux) | http://host.docker.internal:11434 | 不要 |

| MacOS | http://host.docker.internal:11434 | 不要 |

これらの設定が完了すると、DifyからOllamaのAIモデルを利用できるようになります。最後にDifyでチャットボットを作成する手順を紹介します。

DifyでOllamaを連携したチャットボットを作成する手順

チャットボットを作成

- Difyの上のメニューから「スタジオ」をクリックします。

- 「アプリを作成する」の「最初から作成」を選びます。

- アプリの種類として「チャットボット」を選びます。

- チャットボットの基本情報を設定します。

アイコン:チャットボットのアイコン画像を選択

名前:チャットボットの名前を入力

説明:チャットボットの説明や用途を入力

- 「作成する」ボタンをクリックします。

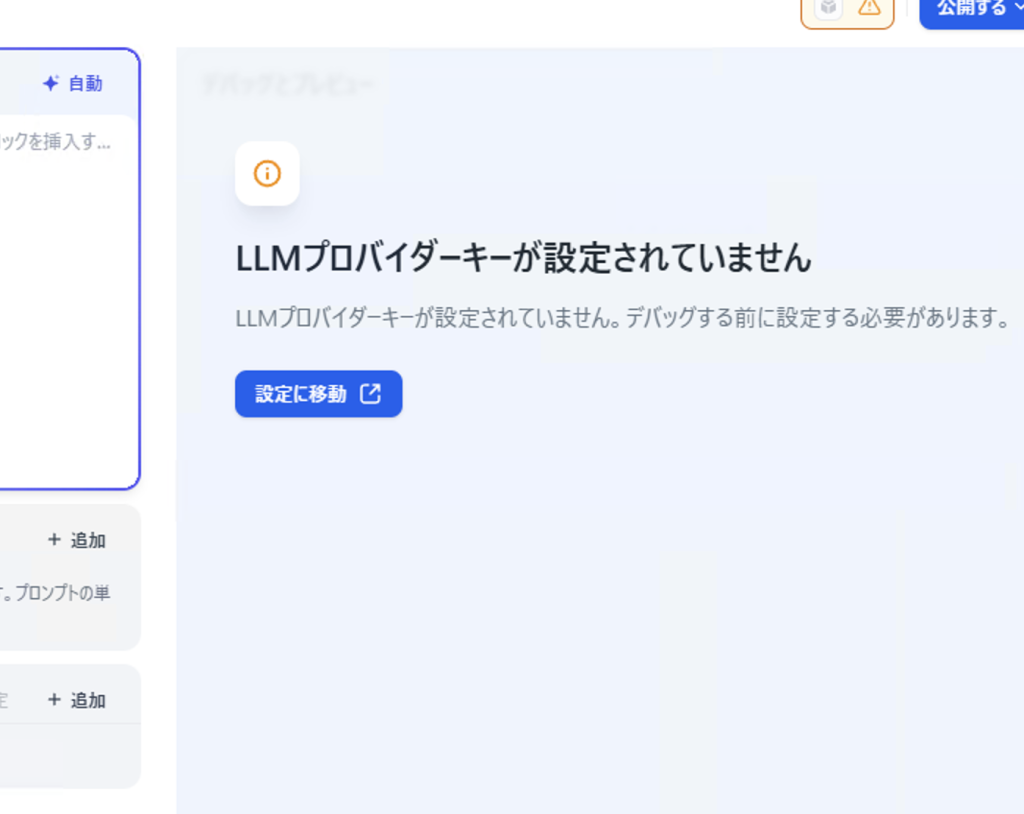

- 遷移した先の画面の「設定に移動」をクリックします。

チャットボットの設定

- モデル設定画面で、モデルプロバイダーとして「Ollama」を選び、プラグインをインストールします。

- インストールした後、ollamaの設定を行います。例えば次の画像の通りです。

- チャットボットの動作方法を指示するプロンプトを入力します。例えば次のように設定します。

- 必要に応じて、「設定」タブで応答の長さや創造性の度合いなどを調整します。

チャットボットの実行と公開

- 画面右側のプレビュー部分で、実際にチャットボットと会話をしてみます。

- 質問を入力し、チャットボットの応答を確認します。

- 応答が期待通りでない場合は、設定を見直して調整します。

- 問題なく動作することを確認したら、画面上部の「公開」ボタンをクリックします。

- 公開方法を選ぶと、チャットボットが動作します。

| 公開方法 | 動作 |

| アプリを実行 | リンクを知っている人だけがアクセス可能に |

| サイトに埋め込む | ローカルウェブサイトにチャットボット埋め込み可能に |

| ”探索で開く” | 探索画面に遷移します。 |

| APIリファレンスにアクセス | ローカルアプリケーションからチャットボットを利用可能に |

DifyとOllamaを連携させれば、専門的な知識がなくても、高性能なAIチャットボットを簡単に作成・公開・管理できます。自分のパソコンで動くAIを活用すれば、プライバシーを守りながら、コストを抑えて、様々な用途に対応したチャットボットを実現できます。

よくある質問

DifyとOllamaとは何ですか?

Dify(ディファイ)は、AIアプリケーションを簡単に開発・運用するためのプラットフォームです。プログラミングの知識があまりなくても、画面操作でプロンプトの設計や外部データ(RAG)との連携、チャットボットの発行などができます。

Ollama(オラマ)は、Llama 3やMistralといったオープンソースの大規模言語モデル(LLM)を、自分のパソコン(Windows, Mac, Linux)で簡単に実行するためのツールです。

この二つを連携させることで、Difyの使いやすい開発環境と、Ollamaで動く自分だけのAIモデルを組み合わせることができます。

DifyとOllamaを連携させる一番のメリットは何ですか?

主に以下の3つの大きなメリットがあります。

- プライバシーとセキュリティの確保: 入力したデータや会話履歴が外部のサーバーに送信されないため、機密情報や個人情報を含む業務でも安心して利用できます。

- コストの削減: OpenAIなどのAPIを利用する際に発生する従量課金を気にする必要がありません。一度環境を構築すれば、自分のパソコンの性能が許す限り、無料でAIを動かせます。

- 開発の手軽さ: 専門的な知識がなくても、Difyの直感的なインターフェースを使って、高性能なAIチャットボットを素早く構築し、公開・管理まで一貫して行えます。

始めるには何が必要ですか?

以下のものが必要です。

- パソコン: ある程度のスペックを持つWindows、Mac、またはLinuxのPC。

- Ollamaのインストール: 公式サイトからダウンロードしてインストールします。

- AIモデル: コマンド一つ(例:

ollama run llama3)で好きなモデルをダウンロードします。 - Difyのアカウント: Difyのクラウド版に登録するか、自分でサーバーにDifyをインストール(セルフホスト)します。

どのくらいのスペックのパソコンが必要ですか?

実行するAIモデルのサイズによって異なりますが、一般的にRAM(メモリ)の容量が最も重要です。

- 最低ライン: 7B(70億パラメータ)クラスの小規模モデルで、最低でも8GBのRAMが必要です。快適に動かすには16GBを推奨します。

- 推奨ライン: 13B(130億パラメータ)以上の中規模モデルを試すなら16GB〜32GBのRAMがあると安心です。

- GPUについて: 高速な応答を求めるなら、NVIDIA製のGPU(VRAM搭載)があると非常に効果的ですが、必須ではありません。CPUだけでも動作します(応答速度は遅くなります)。

設定は難しいですか?専門知識は必要ですか?

基本的な設定であれば、専門的なプログラミング知識は不要です。

Ollamaのインストールは数クリックで完了し、Dify上での設定も、Ollamaが動作しているPCのURLを指定するだけで連携が完了します。Webサイトの基本的な設定を経験したことがある方なら、問題なく進められるレベルです。

作成したチャットボットは他人にも使ってもらえますか?

はい、可能です。

Difyには、作成したアプリケーションをWebサイトに埋め込んだり、スタンドアロンのWebアプリとして公開したりする機能があります。ただし、チャットボットを常時稼働させておくには、Ollamaを動かしているパソコンの電源を常にONにしておく必要があります。

具体的に、どのようなチャットボットが作れますか?RAGはできますか?

DifyのRAG(Retrieval-Augmented Generation)機能を使えば、様々な応用が可能です。

- 社内規定・マニュアルの問い合わせ窓口: PDFやテキストファイルを読み込ませ、社内のルールに関する質問に自動で回答するボット。

- 自分専用の学習アシスタント: 特定の専門分野の論文や資料を学習させ、自分の研究や学習をサポートするボット。

- Webサイトのカスタマーサポート: WebサイトのFAQや商品情報を読み込ませ、顧客からの質問に24時間対応するボット。