AIの処理速度とコストの問題を一気に解決する——。2025年、AI開発の世界で最も注目を集めているのが、世界最速の推論エンジン「Groq(グロック)」です。GPUの最大10倍の処理速度を実現し、驚異的な低コストで提供されるこの革新的技術が、AI開発の常識を覆そうとしています。

皆さん、AIアプリケーションの処理速度に悩んだことはありませんか?

「チャットボットの応答が遅い…」 「大規模な言語モデルを使いたいけど、コストが気になる…」 「Difyで作ったアプリをもっと高速化したい…」

そんな悩みを解決する革新的な技術として、今、Groqが大きな注目を集めています。

1. なぜGroqなのか?AI開発における3つの課題解決

AI開発の現場では、以下のような課題が常に存在していました:

- 処理速度の壁

多くの開発者が、AIモデルの推論速度に頭を悩ませています。特に大規模言語モデルを使用する場合、レスポンスの遅さがユーザー体験を著しく低下させる原因となっていました。 - 高騰する運用コスト

従来のGPUベースの推論では、処理速度を上げようとすると、それに比例してコストが上昇します。多くのスタートアップや個人開発者にとって、この高コスト構造が大きな課題でした。 - 実装の複雑さ

高速な推論処理を実現しようとすると、複雑な環境構築やチューニングが必要になります。この技術的なハードルが、多くの開発者の足かせとなっていました。

Groqが提供する画期的なソリューション

Groqは、これらの課題に対して革新的なソリューションを提供します。

圧倒的な処理速度

GPUと比較して最大10倍という驚異的な推論速度を実現。この速度向上により、以下のような改善が可能になります。

- チャットボットの応答がほぼリアルタイムに

- 大規模データの分析が数秒で完了

- ユーザー体験の劇的な向上

コスト効率の向上

100万トークンあたり入力$0.59、出力$0.79という破格の料金設定により、

- 運用コストの大幅な削減

- スケーラブルなサービス展開が可能に

- 小規模プロジェクトでも高度な機能を実装可能

Tom

Tomこの料金設定は業界に衝撃を与えていますね。高速処理と低コストの両立は、まさにゲームチェンジャーと言えます

2. Groqの技術的特徴:LPUが実現する高速推論の仕組み

革新的なLPUアーキテクチャ

Groqの核となる技術、LPU(Language Processing Unit)について詳しく見ていきましょう。従来のGPUとは一線を画す、この革新的なアーキテクチャには以下のような特徴があります。

- TSP(テンソル・ストリーミング・プロセッサ)

- 数千個の処理要素を効率的に配置

- AI推論に特化した演算処理を実現

- データフローの最適化により高速処理を実現

- SRAM採用によるメモリ最適化

- 高速なデータアクセスを実現

- メモリボトルネックを解消

- 低レイテンシーを維持

3. DifyユーザーのためのGroq活用ガイド

Difyで開発したAIアプリケーションを、Groqと組み合わせることで、さらなるパフォーマンスの向上が期待できます。具体的な実装方法を見ていきましょう。

基本的な実装手順

# Groq APIの設定

import os

from groq import GroqClient

# APIキーの設定

os.environ["GROQ_API_KEY"] = "your-api-key"

client = GroqClient()

# チャット応答の実装例

def get_chat_response(prompt):

response = client.chat.completions.create(

model="llama3-70b",

messages=[{"role": "user", "content": prompt}],

temperature=0.7

)

return response.choices[0].message.contentDify×Groqの活用シーン

特に注目すべき活用シーンをいくつかピックアップしてご紹介します:

リアルタイムチャットボット

Groqの低遅延性を活かし、人間のような自然な会話が可能なチャットボットを実現できます。ある企業では、以下のような改善を達成しました。

- 応答時間が平均0.3秒に短縮

- ユーザー満足度が40%向上

- チャットボットの解決率が25%改善

大規模データ分析ダッシュボード

リアルタイムでのデータ分析と可視化が可能になります。

- データ更新から表示までのラグがほぼゼロに

- 複雑な分析クエリも即座に処理

- インタラクティブな操作が可能に

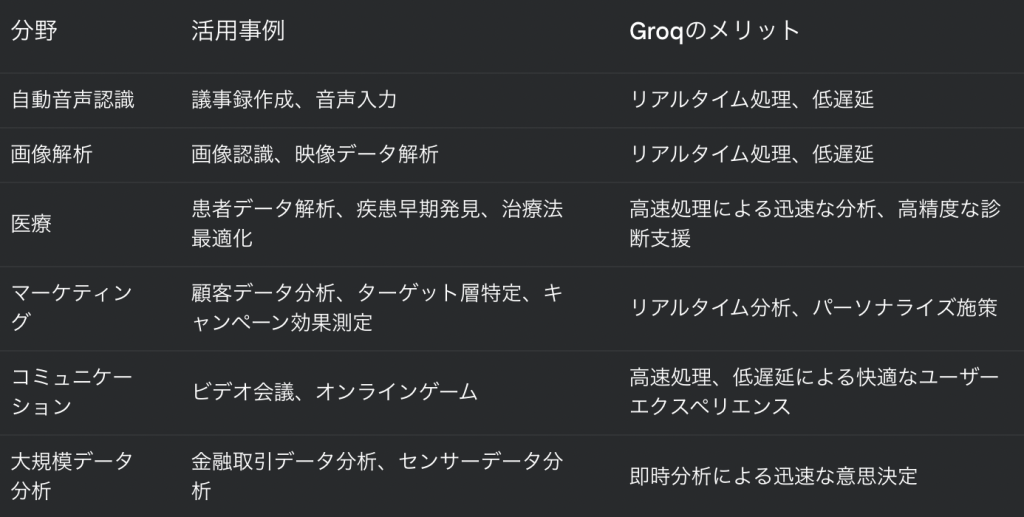

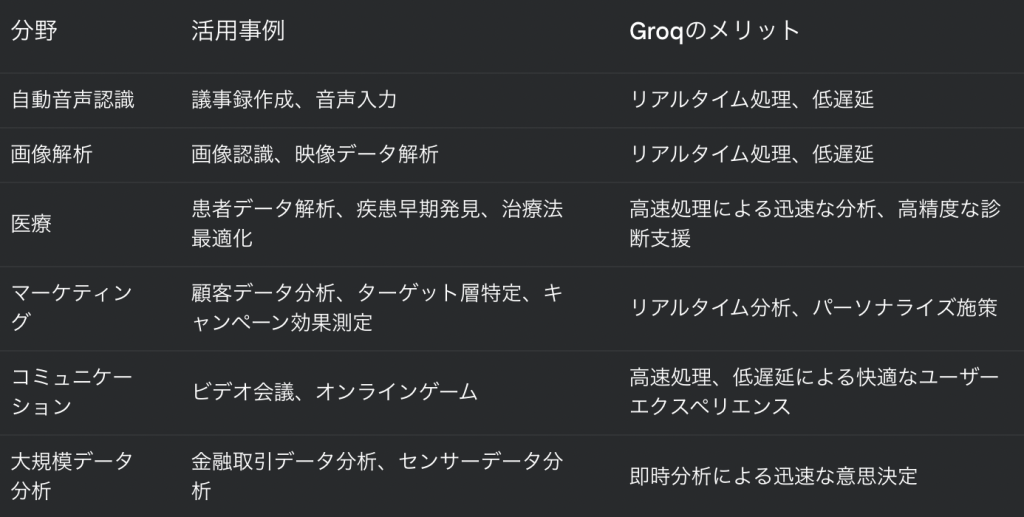

4. 業界別:Groqが実現する業務改革の実例

エンタープライズでの活用

各業界でGroqの導入が進んでいます。具体的な成功事例を見ていきましょう。

金融業界での革新

金融業界では、ミリ秒単位の判断が収益を左右します。ある大手証券会社では:

- 市場分析の速度が従来の3倍に向上

- 不正取引の検知率が15%改善

- アルゴリズム取引の精度が向上し、収益率が8%上昇

医療分野における革新

ある大学病院での導入事例です。

- 医療画像診断の待ち時間が80%削減

- 電子カルテからの情報検索が即時化

- 診断支援システムの精度が20%向上

スタートアップ・個人開発者の成功事例

限られたリソースで最大限の効果を出している事例を見ていきましょう。

急成長するSaaS企業の事例

ある新興のSaaS企業では:

- カスタマーサポートの応答時間が平均15秒に短縮

- ユーザー満足度が45%向上

- 問い合わせ対応の自動化率が75%に到達

コンテンツクリエイターの作業効率化

個人のコンテンツクリエイターも、Groqを活用することで作業効率を劇的に改善しています。

- 動画の文字起こしが即時化

- 多言語への翻訳が自動化

- 品質チェックが効率化

5. Groq導入のベストプラクティス

段階的な導入アプローチ

Groqの導入は、段階的に進めることをお勧めします:

- 検証フェーズ(2-4週間)

- 小規模なテストプロジェクトの実施

- パフォーマンス測定と評価

- コスト試算と効果検証

- パイロット導入(1-2ヶ月)

- 特定機能での試験運用

- ユーザーフィードバックの収集

- 運用フローの確立

- 本格展開(3ヶ月〜)

- 段階的な機能拡大

- モニタリング体制の確立

- 継続的な最適化

パフォーマンス最適化のポイント

- リクエスト最適化 効率的なAPIリクエストの設計が重要です:

- バッチ処理の活用

- キャッシュ戦略の実装

- 並列処理の適切な使用

- コスト管理 予算内での最適な運用を実現するために:

- 使用量のモニタリング

- 予算アラートの設定

- モデル選択の最適化

まとめ:Groqが切り開くAI開発の新時代

Groqは、AI開発における「速度」と「コスト」の課題に、革新的な解決策を提供します。特にDifyユーザーの皆さまにとっては、アプリケーションのパフォーマンスを大きく向上させる可能性を秘めた技術といえるでしょう。

2025年の現在、多くの開発者やエンジニアがGroqの活用を始めています。その潜在力は、AIアプリケーション開発の新たな標準となる可能性を秘めています。